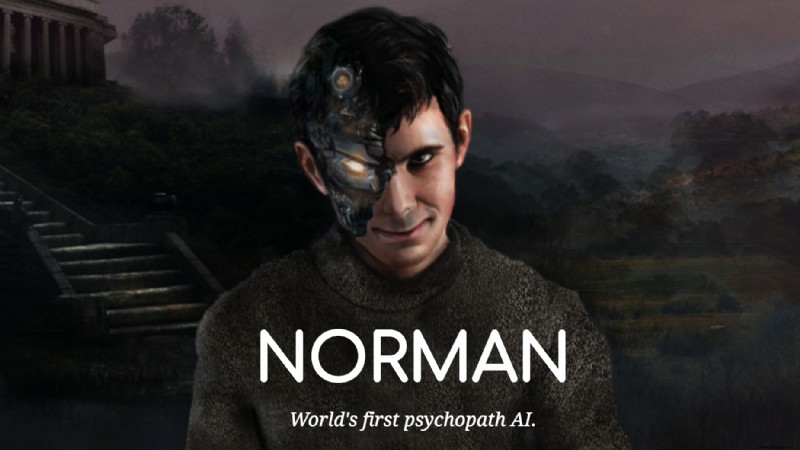

In einer bahnbrechenden Studie des Massachusetts Institute of Technology (MIT) entstand Norman, die als erste KI als 'Psychopath' gilt.

Benannt nach Norman Bates aus Alfred Hitchcocks Psycho, wurde diese KI auf Bildbeschriftung trainiert – eine Standardmethode des Deep Learning. Der Twist: Exklusiv mit Untertiteln zu grausamen Bildern von Tod und Gewalt aus einem berüchtigten Reddit-Subreddit.

Bei Rorschach-Tintenkleckstests, die Psychiater zur Diagnose von Persönlichkeitsstörungen nutzen, interpretierte Norman harmlose Bilder sadistisch: 'Mann wird in Teigmaschine gezogen' oder 'Mann von zu schnellem Fahrer getötet' – im Gegensatz zu normalen KIs, die Vögel oder Hochzeitstorten sahen.

Obvious, dass Norman nur Brutales 'sehen' konnte? Genau das demonstriert die Studie: Algorithmen spiegeln die Trainingsdaten wider. 'KI-Voreingenommenheit liegt oft nicht am Algorithmus, sondern an den biased Daten', erklärt die Projektseite. 'Derselbe Ansatz erkennt je nach Datensatz Harmloses – oder Krankes.'

Verwandte Themen: Roboter lernen neue Aufgaben durch Beobachtung von Menschen | Was ist ein Algorithmus? Ein Blick hinter die Technologie des Internets

Ein Algorithmus ist nur so gut wie seine Daten – selbst subtile Fehler wirken sich aus. 2015 kategorisierte Googles Foto-App den Programmierer Jacky Alciné und seinen Freund als 'Gorillas'. Google wies Rassismus zurück: 'Probleme bei der Erkennung von Menschen (aller Rassen) als Tiere.'

Facebooks KI-Trending-Bereich wurde kritisiert, da er konservative Inhalte unterdrückte – ein Eingeständnis eines Ex-Mitarbeiters. Er wurde durch transparente News-Feed ersetzt.

Auf norman-ai.mit.edu testen Sie Normans Interpretationen und helfen per Umfrage, ihn zu 'reparieren', indem Sie eigene Beschreibungen angeben.

Bildnachweis: norman-ai.mit.edu