Das neueste Projekt von Google DeepMind ermöglicht es KI-Systemen, Ereignisse in der realen Welt zu verstehen. Dazu analysiert die KI einen umfangreichen Katalog von Videodateien, um die Umwelt, in der sie agiert, eigenständig zu erfassen.

Bisherige DeepMind-Projekte konzentrierten sich auf interne Fähigkeiten wie Textgenerierung, Bildklassifikation oder Bewegungsanalyse in virtuellen Umgebungen. Nun hat das Team eine KI entwickelt, die nach außen blickt und reale Weltphänomene erkennt.

Die KI lernt visuellen und akustischen Konzepten durch das Betrachten kurzer Videoschnipsel selbstständig. Sie versteht Aktionen wie Rasenmähen oder Kitzeln, ohne dass Wörter oder Etiketten vorgegeben wurden – eine Form des unbeaufsichtigten Lernens.

Ähnlich wie beim Symbol-Concept Association Network (SCAN) für Umgebungsinterpretation vermeidet das Projekt Etiketten. Stattdessen matcht die KI Bilder und Geräusche mit realen Beobachtungen.

Diese Methode spiegelt den menschlichen Lernprozess wider, bei dem wir aus sensorischen Eindrücken Konzepte ableiten.

Der Algorithmus nutzt zwei neuronale Netzwerke: eines für Bilderkennung mit Standbildern und eines für Audio mit 1-Sekunden-Clips. Diese wurden mit 60 Millionen Bild-Audio-Paaren aus 400.000 Videos trainiert. Ein drittes Netzwerk verknüpft sie und erkennt Konzepte wie Menschenmengen, Stepptanz oder fließendes Wasser – auch bei neuen Beispielen, etwa Klatschen.

Dieses selbstgesteuerte Lernen bereitet KI für reale Anwendungen vor, in denen sie aus visuellen und auditiven Daten lernt. Aktuelle Entwicklungen finden in kontrollierten Umgebungen statt.

Frühere Erfolge von Google DeepMind

DeepMind interpretiert Umgebungen kindlich-menschlich

Um Problemlösung zu verbessern, orientiert sich DeepMind am menschlichen Denken. Durch konzeptionelle Werkzeuge löst KI komplexe Aufgaben effizient – etwa den Bau eines Abakus aus Ton, Schilf und Holz.

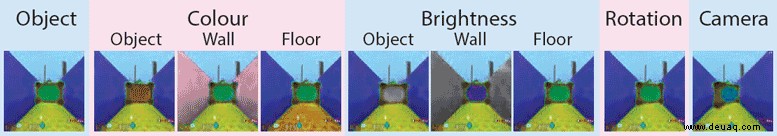

Traditionell fehlt KI die Fähigkeit, Konzepte neu zu kombinieren. Mit SCAN ahmt DeepMind menschliche visuelle Hierarchien nach, wie im Paper „SCAN: Learning Abstract Hierarchical Compositional Visual Concepts“ beschrieben.

Die KI interpretiert Objekte wie Äpfel oder Koffer anhand physikalischer Eigenschaften (Farbe, Form, Position, Beleuchtung) und kombiniert sie mit Beschreibungen. So entsteht ein tiefes Verständnis jenseits reiner Bildabgleiche.

SCAN zerlegt Komponenten und generiert neue Objekte, z. B. ein fiktives „Woog“ als grünes Objekt auf rosa Boden vor gelber Wand.

DeepMind beherrscht das Laufen

DeepMind hat KI das Laufen selbst beibringen lassen – inklusive Balance und Motorkontrolle in Simulationen.

Im Gegensatz zu spezialisierten Robotern wie von Boston Dynamics lernt DeepMind dynamische Anpassung für vielfältige Umgebungen.

Ohne manuelle Bewegungserfassungsdaten trainiert die KI Fortbewegung in komplexen Szenarien: Laufen, Springen, Drehen, Hocken.

In Experimenten wechselte die KI autonom zwischen Gehstilen. Sowohl SCAN als auch Bewegungslering deuten auf eine neue Ära hin: KI lernt weltbezogen wie der menschliche Geist.

Verwandte Themen: Elon Musks Warnungen vor KI-Risiken unterstreichen die Notwendigkeit regulierter Entwicklung.