Suchmaschinen sind weit entfernt von Neutralität. Ihre Algorithmen prägen unser Verständnis von Alltagsfragen bis hin zu geopolitischen Konflikten – besonders in Zeiten, in denen wir uns zunehmend auf das Internet für schnelle Infos stützen. Inmitten von Desinformation und Fake News fungieren sie als Linse unserer Weltwahrnehmung.

Künstliche Intelligenz verstärkt diese Dynamik, indem Suchmaschinen smarter auf Internet-Trends reagieren und autoritative Quellen priorisieren. Die Hoffnung: Faire Repräsentation. Die Sorge: Weniger menschliche Kontrolle eröffnet maschinellem Lernen Raum für Vereinfachungen nuancierter Wahrheiten.

Während Google im Rampenlicht steht, hat Microsoft bei Bing leise Revolutionen eingeleitet. Seit Ende letzten Jahres testet Bing „multiperspektivische Antworten“. Statt reiner Linklisten gruppiert es kontroverse Themen und präsentiert ausgewogene Sichten aus diversen Quellen.

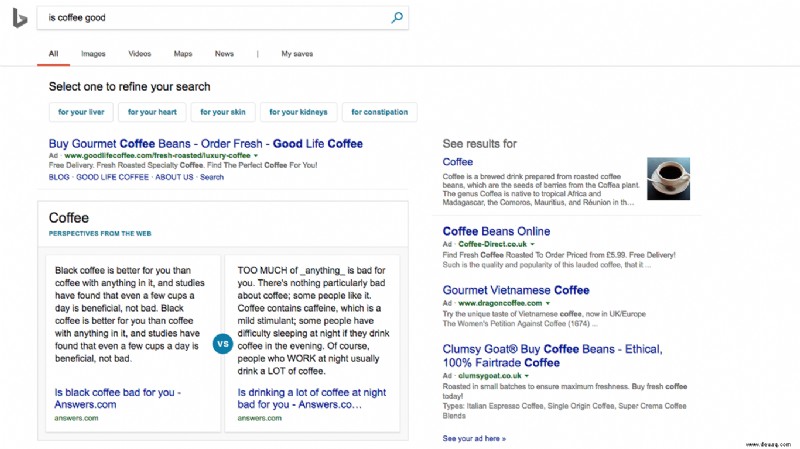

Bei der Suche „Ist Kaffee gut für Sie?“ erscheint oben ein Kästchen mit zwei Perspektiven – getrennt durch ein „vs“-Symbol. Microsofts Jordi Ribas, Corporate Vice President für AI-Produkte bei Bing, erklärt: „Im Klima von Fake News und Fehlinformationen müssen Suchmaschinen umfassende Ergebnisse liefern. Traditionelle Algorithmen verstärken Blasen und Vorurteile. Wir brechen diese auf.“

Diese Vielfalt könnte Nutzer ermutigen, „ihre Wahrheit“ zu wählen, oder falsche Äquivalenzen schaffen – etwa bei Flat-Earth-Theorien. Ribas betont jedoch: Das System bewertet Quellenautorität streng und zielt auf Nuancen, nicht Desinformation.

Derzeit beschränkt sich der Ansatz auf harmlose Themen wie Kaffee oder Cholesterin. Politische Queries wie „Ist Brexit gut?“ oder „Soll Trump angeklagt werden?“ bleiben ohne multiperspektivische Behandlung. Bei „Gibt es einen Gott?“ dominiert eine einseitige Quelle.

Siehe verwandt: It’s not bots, it’s us: Falsche Nachrichten werden viel schneller geteilt als echte Geschichten auf Twitter. Bad News ist das Spiel, das Ihnen etwas über gefälschte Nachrichten beibringt. „Fake News“ ist zu einem Geschäftsmodell geworden, argumentieren Forscher.

Ribas gibt zu: Die Abdeckung ist derzeit gering. „Wir verfeinern die KI, um Autorität besser zu erkennen und objektivere Ergebnisse zu erzielen. Fehler sind unvermeidbar, aber wir streben Vertrauenswürdigkeit an.“ Bing nutzt Stimmungsanalyse, um Queries zu clustern und autoritätsbasierte Gewichtungen vorzunehmen.

Publisher können sich über pubhub.bing.com als verifizierte Quelle qualifizieren. Kriterien: Nachrichtenwert, Originalität, Autorität, Lesbarkeit – inklusive manueller Prüfung durch Journalisten.

Zuverlässige KI

Trotz Limits steht Ribas für „trustworthy AI“. Klare Parameter verhindern Bias durch Trainingsdaten. „KI lernt, braucht aber Leitlinien für unvoreingenommene Daten“, sagt er. Microsoft engagiert sich in Partnership on AI und MITs CBMM.

Globaler Wettbewerb heizt ein: China mit SenseTime vorne. Im SQuAD-Test überholte Alibaba Microsoft. Ribas: „Datenschutz und Werte unterscheiden Länder. Wir beobachten die Entwicklung.“

(Jordi Ribas. Bild: Microsoft)

Für Bing geht’s um ethische Suche. Ribas: „Wir wollen Objektivität setzen – und Nutzer gewinnen. Objektivität war nie wichtiger.“