Siehe auch Maschinelles Lernen wird verrückt nach diesen faszinierenden AufklebernAI versus maschinelles Lernen:Was ist der Unterschied?Kein Job zu klein? Wie maschinelles Lernen den Geschäftsalltag übernehmen wird

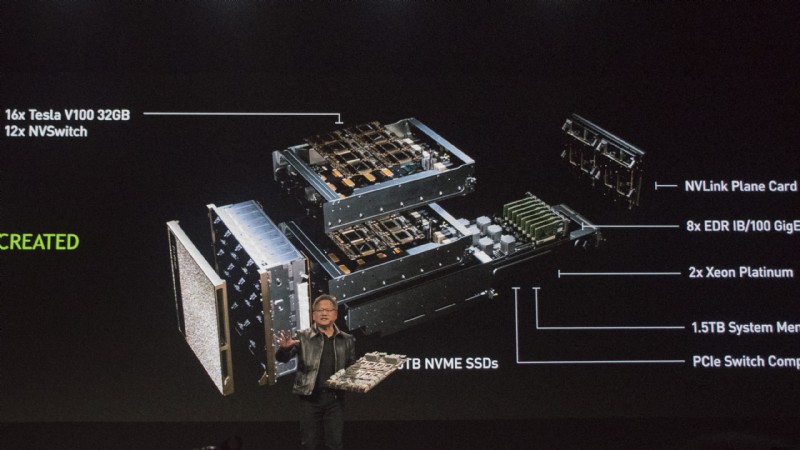

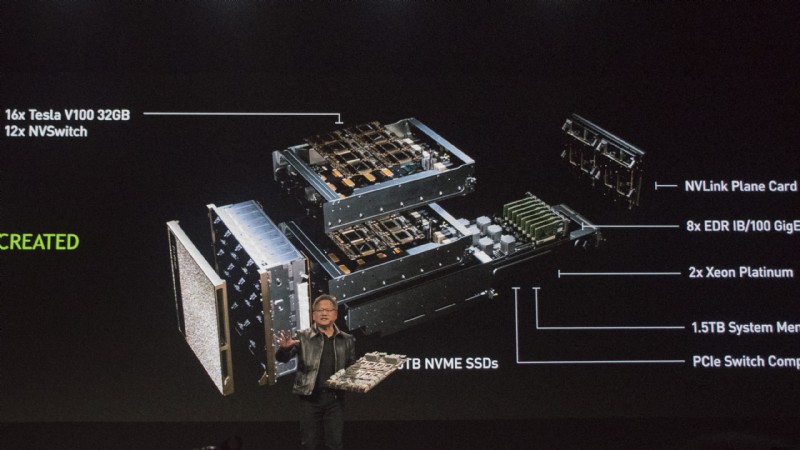

Zu diesem Zweck hat es dedizierte Hardware für maschinelles Lernen in Form des DGX-2 und der neuen Open-Source-Plattform Rapids auf den Markt gebracht. Die GPU-betriebene Plattform für maschinelles Lernen von Nvidia wurde entwickelt, um als vollständige End-to-End-Lösung zusammenzuarbeiten, und wird die Art und Weise, wie Institutionen und Unternehmen ihre Daten verarbeiten und verstehen, grundlegend verändern.

„Datenanalyse und maschinelles Lernen sind die größten Segmente des High-Performance-Computing-Marktes, die nicht beschleunigt wurden“, erklärte Jensen Huang, Gründer und CEO von Nvidia, auf der Bühne der GTC Europe 2018. „Die Die größten Branchen der Welt führen Algorithmen aus, die durch maschinelles Lernen auf einer Vielzahl von Servern geschrieben wurden, um komplexe Muster in ihrem Markt und ihrer Umgebung zu erkennen und schnelle, genaue Vorhersagen zu treffen, die sich direkt auf ihr Endergebnis auswirken.“ WEITER LESEN:KI vs. maschinelles Lernen, was ist der Unterschied? Traditionell fand maschinelles Lernen aufgrund ihrer Verbreitung und der relativen Weiterentwicklung des Mooreschen Gesetzes ausschließlich auf CPU-basierten Systemen statt. Jetzt, wo das Mooresche Gesetz zu Ende ist, ist es an der Zeit für Datenwissenschaftler, eine leistungsfähigere Lösung zu finden, um ihre Rechenmaschinen mit Strom zu versorgen. Es ist ein Markt, der laut Analysten einen geschätzten Wert von 36 Milliarden US-Dollar (26,3 Milliarden Pfund) pro Jahr hat, daher ist es kein Wunder, dass Nvidia ein Stück vom Kuchen abhaben und die Chance haben möchte, den Bereich des maschinellen Lernens mit seinen eigenen Produkten voranzutreiben. P>

„Wir beschleunigen das maschinelle Lernen wie beim Deep Learning“

„Aufbauend auf CUDA und seinem globalen Ökosystem und in enger Zusammenarbeit mit der Open-Source-Community haben wir die GPU-Beschleunigungsplattform Rapids entwickelt“, sagte Huang. „Es lässt sich nahtlos in die weltweit beliebtesten Data-Science-Bibliotheken und -Workflows integrieren, um das maschinelle Lernen zu beschleunigen. "Wir beschleunigen das maschinelle Lernen, wie wir es beim Deep Learning getan haben." Ohne auf all die technischen Fehler hinter all dem einzugehen – und glauben Sie mir, davon gibt es eine Menge – es ist wirklich ziemlich klar, wie viel schneller die GPU-Systeme von Nvidia sind als herkömmliches CPU-Maschinenlernen. WEITER LESEN:Mit neuronalen Netzen Kunst machen  In einem live auf der Bühne präsentierten Beispiel verarbeitete die Nvidia-Plattform in etwa 40 Sekunden die Hypotheken- und Kreditdaten eines großen Hypothekenmaklers aus 16 Jahren. Auf einem traditionellen Python-basierten CPU-System würde das etwa zwei Minuten dauern. Für einen fortgeschritteneren Prozess der Erstellung eines Modells, aus dem eine KI lernen kann, um Verhaltensvorhersagen zu erstellen – wie z. B. die Modellierung, wie wahrscheinlich es ist, dass jemand aufgrund seiner Vergangenheit mit einem Kredit in Verzug gerät – dauert es etwas länger. Auf einem herkömmlichen 100-CPU-System würde es etwa eine halbe Stunde und auf einem 20-CPU-Array noch länger dauern. Als Teil von Nvidias DGX-2-System und Rapids läuft es in ungefähr den zwei Minuten, die Huang brauchte, um zu erklären, was wir gesehen haben. Dies bedeutet natürlich Zeitvorteile für Datenwissenschaftler und erhöht das Lerntempo für Unternehmen. Wie Huang auch betont, ist ein DGX-2 auch in der Lage, die gleiche Arbeitslast wie 300 Server zu bewältigen. Die Installation könnte einem Unternehmen über 3 Millionen US-Dollar kosten, und bei denselben Ausgaben für DGX-2-Systeme, auf denen Rapids ausgeführt wird, wüsste ein Unternehmen einfach nicht, was es mit dieser Rechenleistung anfangen soll. WEITER LESEN:Googles Cloud AutoML hofft, maschinelles Lernen für alle zugänglich zu machen Es ist auch nicht alles heiße Luft, da Nvidia bereits große Unternehmen hatte, die seine GPU-beschleunigte Plattform für maschinelles Lernen unterstützen. Walmart hat damit begonnen, es zu verwenden, um die Bestandsverwaltung und Prognosen zu verstehen und sicherzustellen, dass Lebensmittelabfälle in seinen Filialen drastisch reduziert werden können. In den Technologiebereichen hat sich HPE mit Nvidia zusammengetan, um seine Angebote für maschinelles Lernen für seine Kunden zu verbessern; IBM beabsichtigt, es mit seiner Watson-KI und einer Vielzahl anderer von ihm ausgeführter maschineller Lernprogramme zu verwenden, und Oracle nutzt seine Open-Source-Rapids-Plattform und eine Suite von DGX-2, um Einblicke in seine Oracle Cloud-Infrastruktur zu gewinnen. Letztendlich sollen Rapids und DGX-2 die Möglichkeiten des maschinellen Lernens für neue Märkte und Unternehmen erschließen. Unternehmen, die nicht über das Budget oder die Fähigkeiten verfügen, Server-Racks zu betreiben oder Unmengen von Datenwissenschaftlern einzustellen, könnten dies jetzt tun. Es ist eine Technologie, die zwar nicht von Natur aus sexy ist, aber einen enormen Einfluss darauf haben könnte, wie Unternehmen in Zukunft funktionieren.

In einem live auf der Bühne präsentierten Beispiel verarbeitete die Nvidia-Plattform in etwa 40 Sekunden die Hypotheken- und Kreditdaten eines großen Hypothekenmaklers aus 16 Jahren. Auf einem traditionellen Python-basierten CPU-System würde das etwa zwei Minuten dauern. Für einen fortgeschritteneren Prozess der Erstellung eines Modells, aus dem eine KI lernen kann, um Verhaltensvorhersagen zu erstellen – wie z. B. die Modellierung, wie wahrscheinlich es ist, dass jemand aufgrund seiner Vergangenheit mit einem Kredit in Verzug gerät – dauert es etwas länger. Auf einem herkömmlichen 100-CPU-System würde es etwa eine halbe Stunde und auf einem 20-CPU-Array noch länger dauern. Als Teil von Nvidias DGX-2-System und Rapids läuft es in ungefähr den zwei Minuten, die Huang brauchte, um zu erklären, was wir gesehen haben. Dies bedeutet natürlich Zeitvorteile für Datenwissenschaftler und erhöht das Lerntempo für Unternehmen. Wie Huang auch betont, ist ein DGX-2 auch in der Lage, die gleiche Arbeitslast wie 300 Server zu bewältigen. Die Installation könnte einem Unternehmen über 3 Millionen US-Dollar kosten, und bei denselben Ausgaben für DGX-2-Systeme, auf denen Rapids ausgeführt wird, wüsste ein Unternehmen einfach nicht, was es mit dieser Rechenleistung anfangen soll. WEITER LESEN:Googles Cloud AutoML hofft, maschinelles Lernen für alle zugänglich zu machen Es ist auch nicht alles heiße Luft, da Nvidia bereits große Unternehmen hatte, die seine GPU-beschleunigte Plattform für maschinelles Lernen unterstützen. Walmart hat damit begonnen, es zu verwenden, um die Bestandsverwaltung und Prognosen zu verstehen und sicherzustellen, dass Lebensmittelabfälle in seinen Filialen drastisch reduziert werden können. In den Technologiebereichen hat sich HPE mit Nvidia zusammengetan, um seine Angebote für maschinelles Lernen für seine Kunden zu verbessern; IBM beabsichtigt, es mit seiner Watson-KI und einer Vielzahl anderer von ihm ausgeführter maschineller Lernprogramme zu verwenden, und Oracle nutzt seine Open-Source-Rapids-Plattform und eine Suite von DGX-2, um Einblicke in seine Oracle Cloud-Infrastruktur zu gewinnen. Letztendlich sollen Rapids und DGX-2 die Möglichkeiten des maschinellen Lernens für neue Märkte und Unternehmen erschließen. Unternehmen, die nicht über das Budget oder die Fähigkeiten verfügen, Server-Racks zu betreiben oder Unmengen von Datenwissenschaftlern einzustellen, könnten dies jetzt tun. Es ist eine Technologie, die zwar nicht von Natur aus sexy ist, aber einen enormen Einfluss darauf haben könnte, wie Unternehmen in Zukunft funktionieren.